רובוטים באינטרנט (המכונים לעתים spiders , wanderers או זחלנים) הם תוכנות המשוטטות באתרים באינטרנט על ידי קפיצה מקישור לקישור. רובוטים מדלגים בין האתרים, ואוספים מידע, לבחירת בעליהם.

רובוטים מפורסמים הם הרובוטים של מנועי החיפוש, הסורקים את הרשת ללא הפסקה במטרה לאתר דפים שהשתנו מאז ביקורם האחרון. GoogleBot, למשל, הוא שמו של הרובוט של גוגל, שהוא למעשה עשרות אלפי מחשבים המחוברים לרשת האינטרנט וסורקים אותה. זחלן מפורסם נוסף הוא התוכנה Screaming Frog, שעובד בצורה דומה וזוחל מקישור לקישור.

קצת היסטוריה

כבר בסביבות 1993 התעורר הצורך להגביל את תנועתם של הרובוטים לאחר שנכנסו למקומות שבעלי האתרים לא היו מעוניינים שהנ" ל יגיעו אליהם, כגון קבצים זמניים בשרת, מידע כפול או קבצים שמיועדים לשימוש בני אדם (למשל מילוי טפסים) שאין סיבה שרובוטים יפנו אליהם. עקב צורך זה הוחלט ליצור מנוע שבעזרתו יהיה ניתן להגביל את תנועת הרובוטים. זאת היתה בעיה, כי זחלנים יכלו לערוך שינויים באתרים חיים או בתוכנות, או לחלופין לפרסם תגובות, פוסטים או לשלוח מיילי ספאם – רק באמצעות לחיצה על כפתורים כחלק מהסריקה.

השיטה שנבחרה כדי להגביל רובוטים היא הוספת קובץ לשרת שיגדיר עבור רובוטים לאן מותר להם להיכנס ולאן אסור.

יתרון חשוב של שיטה זו הוא שניתן לממש אותה בקלות על כל שרת HTTP קיים, ללא צורך בשינויים בתוכנה, וכן הרובוט מקבל את המידע על זכויותיו בבקשת HTTP בודדת, ואינו מעמיס את השרת.

מה הקובץ עושה?

קובץ הרובוט צריך להיות נגיש דרך HTTP בכתובת בשרת /robot.txt, כלומר site.com/robot.txt, בדומה לצפייה במפת האתר בכתובת site.com/sitemap.xml.

אם אתם מכניסים את כתובת האתר, מוסיפים robot.txt ומגיעים לעמוד 404 – או שלא הכנסתם את הכתובת כמו שצריך, או ש(עדיין)אין לכם קובץ כזה באתר.

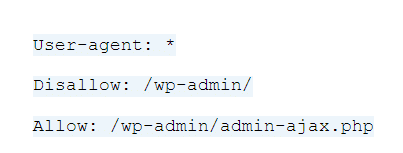

באתרי וורדפרס ברירת המחדל היא שיש רובוט וזה המבנה שלו:

באמצעות הקובץ יכול בעל אתר לקבוע אילו מהדפים בו יהיו נגישים למנועי החיפוש ולרובוטים אחרים. על ידי הסתרת חלקים לא חשובים באתר בעל אתר יכול למקד את תשומת ליבם של מנועי החיפוש בתוכן העיקרי של האתר, במקום לבזבז כוח על דפים שאינם אמורים כלל להראות, כמו עמוד תודה, עמוד עגלה, עמודים שעשוים להיות תוכן משוכפל כמו עמודי תגיות או עמודי גרסה להדפסה, עמודי רשימת מוצרים (קטגוריה) אחרי הרבה פילטרים.

מתי נרצה להשתמש בקובץ robots.txt?

כל דף באתר שלנו מאונדקס כברירת מחדל על ידי מנועי החיפוש. ישנם מקרים בהם לא נרצה שמנועי החיפוש יאנדקסו דפים באתר שלנו:

- שמירה על פרטיות הגולשים – הסתרת דפים הכוללים מידע אישי על הגולשים (כרטיס ביקור של גולש באתר, למשל), כדי שאנשים לא יוכלו לגלות פרטים על האנשים רק על ידי חיפוש במנוע חיפוש.

- מיקוד מנוע החיפוש בדפים החשובים – רלוונטי במיוחד באתרים עם מערכות פורומים שבהן נוצרים על ידי המערכת דפים דינמיים רבים, שאינם מעניינים ברובם (דף " תגובה" לכל הודעה בפורום, למשל). על ידי הוראה למנועי החיפוש להתעלם מדפים אלו, אנחנו יכולים למקד את מנועי החיפוש בדפים העיקריים של האתר ולגרום להם להיסרק באופן טוב יותר.

בשני המקרים נשתמש בקובץ robots.txt בדומה לדוגמאות שהצגנו קודם, ונחסום את גישת הרובוטים אל הדפים הרצויים.

כדאי לדעת שאם לעמוד שחסום לסריקה על ידי robot.txt יש קישור מאתר אחר – יכול להיות שכשגוגל יסרקו את האתר המקשר, הוא יאנדקס גם את העמוד שאתם חסמתם לסריקה.

אפשר לבדוק אם עמוד כלשהו חסום באמצעות Google Search Console, בקישור הזה.

התראות ב-ZEFO על שגיאות robot.txt

- התראה על כל האתר שחסום לסריקה: בהרבה אתרים שנבנים על סביבת פיתוח, יוצרים קובץ ה-robot.txt שחוסם את כל האתר לסריקה של מנועי חיפוש. אם הקובץ נשאר גם כשמעלים את האתר לאוויר, האתר עלול להעלם ממנוע החיפוש (כי הקובץ אומר לרובוטים לא לסרוק את האתר). במצב כזה מתקבלת התראה של ZEFO תחת תוכן -> אופטימיזציה.

- עמודי נחיתה חסומים: דפי הנחיתה המקודמים מופיעים תחת תוכן-> דפי נחיתה. אם אחד מעמודי הנחיתה האלו חסום על ידי robot.txt – מתקבלת התראה. ההתראה תופיע גם בתוכן -> אופטימיזציה.

יצירת קובץ robot.txt

ישנן כמה דרכים ליצור קובץ robot.txt:

- באתרי וורדפרס, תוספי SEO כמו Yoast מאפשרים עריכת קובץ הrobot.txt, תחת SEO->Tools->File Editor (האפשרות קיימת רק "ביטול עריכת קבצים" אם לא מופעל).

- אתרים שיצרו עבורכם קובץ רובוט, למשל האתר הזה.

- כתיבה של הקובץ בעצמכם, בעורך טקסט.

מבנה הקובץ robots.txt

הקובץ מורכב משורות שמופרדות ביניהם על ידי סימן מעבר שורה.

כל שורה בקובץ היא מהמבנה:

<field> : <optionalspace> <value> <optionalspace>

ניתן להוסיף הערות לקובץ על ידי הסימן #. כל תו שיופיע אחרי הסולמית יחשב כהערה. כל רשומה בקובץ מתחילה ב-User-agent, ולאחר פקודה/פקודות Disallow.

לפי הפרוטוקול, הרובוטים מתעלמים משורות שאינם במבנה זה.

- User-agent הוא משתנה שאומר עבור איזה רובוט ההוראה מיועדת, לאחר שנכתוב את הערך ב-User-agent נציין את שם הרובוט

- הרצוי, מופרד על ידי נקודותיים. ניתן לתת הוראות עבור כל הרובוטים על ידי שימוש בתו * (כוכבית).

Disallow הוא משתנה שאחריו תופיע מחרוזת המציינת כתובת אליה לרובוט אסור להיכנס. הכתובת יכולה להיות כתובת מלאה או כתובת חלקית. הרובוט לא יכנס לשום דף שמתחיל בכתובת זו. למשל, ערכים אפשריים הם /files/vbrun.exe או /files/ - אם לאחר Disallow לא מוכנס ערך, המשמעות היא שהרובוט רשאי לעשות כרצונו.

- אם הקובץ /robots.txt קיים וריק, ללא כל תוכן, כל הרובוטים יראו עצמם כמוזמנים.

דוגמאות לקבצי robots.txt

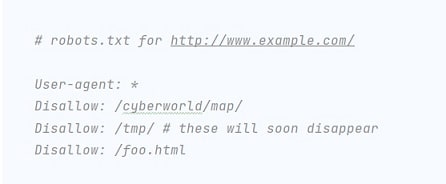

- דוגמה 1

בדוגמא זו, אף רובוט (*) לא יכנס אל /cyberworld/map/ וכן לא אל הספרייה /tmp/ ואל הקובץ foo.html.

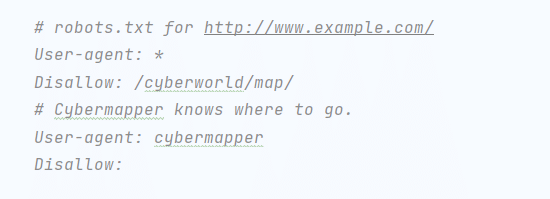

- דוגמה 2

בדוגמא זו אף רובוט לא יכנס אל /cyberworld/map/ מלבד רובוט בשם cybermapper שלו ניתנת גישה חופשית לאתר.

- דוגמה 3

קובץ robots.txt שיכיל טקסט זה ימנע מרובוטים להיכנס אל כל קבצי האתר.

העלאת קובץ robot.txt

אחרי סיום כתיבת הקובץ ועריכתו, צריך להעלות אותו בחזרה לשרת האחסון ולהגיש אותו לגוגל. אם השרת שלכם מאפשר את זה, ניתן להעלות את הקובץ ישירות, אם לא – ניתן להעלות אותו באמצעות תוכנות כמו Filezilla.

דגשים חשובים בהגשת הקובץ:

- שם הקובץ חייב להיות robot.txt

- לכל אתר יכול להיות קובץ robot.txt אחד בלבד

- מיקום הקובץ צריך להיות ב-root, ולא בתוך תיקייה.

אחרי העלאת הקובץ לשרת, כדאי לבדוק שהתוכן עלה בצורה תקינה. יש לכך כמה אפשרויות:

- לראות את תוכן קובץ ה-robot.txt בדפדפן שלכם (site.com/robot.txt) ולהסתכל שם על התוכן שלו.

- robots.txt Tester בגוגל סרצ' קונסול.

- ספריית קוד פתוח של גוגל בגיטהאב, שמאפשרת לבדוק את הקובץ לוקלית על המחשב.

להרחבה

מדריך של גוגל המפרט את השימוש, המגבלות ואיך ליצור את קובץ robot.txt:

מבוא לקבצי robot.txt

מדריך של גוגל על קובץ robot.txt – המבנה שלו,פקודות נפוצות ודוגמאות:

בניית קובץ robot.txt